In queste ore non si fa che parlare di una notizia falsa a cui hanno abboccato tutte le testate giornalistiche più importanti del paese. Sto parlando della eredità lasciata a Berlusconi da parte di una impiegata di uno dei ministeri del nostro paese. La notizia si può trovare un po’ dappertutto (come per esempio qui oppure qui). Ma basta fare una semplice ricerca su un qualsiasi motore per trovarla ormai modificata per quella che è, ovvero una bufala. Il problema delle “bufale” o delle fake news, in realtà, non è solo contemporaneo. Oggigiorno le notizie circolano molto velocemente ed è più facile che le bufale raggiungano in poco tempo milioni di persone grazie alla rete. Tuttavia, le fake news sono sempre esistite. Ne volete un esempio? Avete mai sentito parlare della Minzogna saracina? Probabilmente no. Bisogna essere degli storici per conoscerla, o dei letterati come Leonardo Sciascia che ne ha scritto nel suo romanzo Il consiglio d’Egitto.

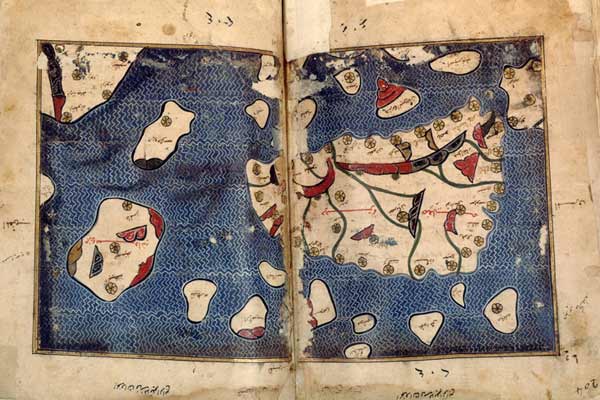

Mappa dell’Emirato di Sicilia, dalla Tabula Rogeriana di Muhammad al Idrisi, 1154.

Nel 1782, monsignor Giuseppe Vella, giunto in Sicilia dalla vicina Malta, divenne famoso come uno dei pochi, se non unico, cultore di lingua araba del Regno delle due Sicilie che si trovava sotto il dominio Borbonico. A cosa era dovuta questa fama? Al fatto che, trovandosi ad essere cappellano nel monastero di S. Martino delle Scale in Palermo, egli dichiarò di aver trovato e tradotto un antico codice di diritto redatto durante il dominio arabo–normanno. Dal momento che il diritto arabo–normanno era antecedente a quello borbonico, si stabilì in questo modo una matrice autonoma del diritto Siciliano su quello borbonico. Le conseguenze di una tale autonomia sono facilmente intuibili: potevano essere aboliti diritti nobiliari e restaurate casate dimenticate. Insomma, un terremoto a livello politico che raggiunse anche le corti Europee. Monsignor Vella, in realtà, spacciò probabilmente per arabo la sua conoscenza di un dialetto maltese. L’ignoranza diffusa fece il resto. C’è da dire che non tutti caddero nel tranello: Rosario Gregorio, uno dei più importanti storici del tardo settecento aveva sentito puzza di bruciato. Assieme all’esperto di lingue arabe Giuseppe Hager, professore a Vienna, scopre l’inganno e smaschera Vella consentendone la condanna a diversi anni di carcere e al ludìbrio storico. Nonostante quella di Vella si sia rivelata come un’antesignana fake news, ha dato, tuttavia, l’incentivo allo studio ed alla ricerca sulla lingua araba consentendo l’istituzione, nel Regno delle due Sicilie, di studi orientalistici. ∎

In alto: Palazzo dei Normanni (XII secolo) a Palermo.

(foto: F. Köhntopp/Unsplash)

Uno dei cavalli di battaglia dei sostenitori anti–OGM è la biodiversità. La loro idea è che gli organismi modificati geneticamente riducano la biodiversità degli ecosistemi con conseguenti danni ecologici non più risanabili. Essendo ben noto, infatti, che i vari comparti ambientali (residenza di forme di vita diversificate) siano risorse non rinnovabili, i danni ad essi apportati si tradurrebbero nella perdita delle proprietà atte al sostentamento della vita. Questa argomentazione è ampiamente documentata in tantissimi siti web: basta, infatti, ricercare su Google le parole “OGM” e “biodiversità” per venire inondati da centinaia, se non migliaia, di siti anti–OGM. Nel mondo attuale in cui predomina la falsa idea della democraticità della scienza, ne viene che un utente medio (ovvero dalla cultura scientifica non troppo sviluppata) possa pensare che, se tanti, troppi siti web dichiarano il danno degli OGM nei confronti della biodiversità, questo sia un fatto reale (argumentum ad populum[1]) e che la posizione pro-OGM da parte del mondo scientifico nasconda chissà quali trame oscure. Prevale, insomma, l’idea che il rumore di fondo sia paragonabile ed abbia la stessa rilevanza dei segnali, neanche molto sporadici, che si alzano ben al di sopra di tale rumore. Cerchiamo di fare, invece, chiarezza per quanto possibile e vediamo di affrontare il problema nel modo più oggettivo possibile. Affrontare un problema in modo oggettivo vuol dire applicare il metodo scientifico e cominciare, innanzitutto, a definire i contorni entro i quali ci si muove. Per delimitare i contorni anzidetti bisogna capire ciò di cui si parla.

Cosa vuol dire comparto ambientale

È ben noto che l’acqua è un bene indispensabile del quale nessun organismo vivente può fare a meno. È il mezzo che consente la veicolazione dei nutrienti ed è il solvente nel quale si completano tutte le reazioni chimiche che caratterizzano il metabolismo sia animale che vegetale. Contaminare le acque vuol dire renderle inadatte al metabolismo come esso si è sviluppato nel corso degli eoni.[2] Una argomentazione analoga va invocata per il suolo. Anche se meno intuitivamente, il suolo va protetto esattamente come le acque: dal momento che esso è la sede per la produzione alimentare ed è fonte del nostro nutrimento (sembra strano doverlo dire, ma i prodotti che si comprano al supermercato non crescono sui banconi degli stessi), contaminare un suolo o più in generale depauperarlo delle proprietà che lo caratterizzano, vuol dire ridurre drasticamente l’approvvigionamento alimentare in grado di sostenere tutte le forme animali e vegetali che popolano il nostro pianeta.[2]

Anche l’atmosfera ha una importanza fondamentale nel sostenere la vita. È ben noto, infatti, che, grazie alla particolare miscela dei vari gas che la compongono, tutti gli organismi viventi sono in grado di esplicare le proprie funzioni. Rimanendo solo nell’ambito umano, una composizione atmosferica solo in minima parte diversa da quella che conosciamo (ovvero all’incirca 20% di ossigeno molecolare, 79% di azoto molecolare e 1% di altre tipologie di gas) non consentirebbe la nostra sopravvivenza. Infatti, al di sotto del 16% circa di ossigeno molecolare atmosferico moriremmo per asfissia, mentre concentrazioni molto elevate di ossigeno molecolare atmosferico comporterebbero la distruzione delle cellule secondo meccanismi che non sto a descrivere perché al di là degli scopi di questo semplice articolo.[2] I tre sistemi citati, ovvero acque, suoli ed atmosfera (tralascio per semplicità il quarto che è quello dei sedimenti), sono tutti indispensabili al sostentamento della vita come noi la conosciamo e rappresentano tre comparti distinti dell’ambiente in cui viviamo. Pur essendo distinti per la loro natura chimica, essi non sono indipendenti gli uni dagli altri, ma sono interconnessi secondo uno schema semplificato del tipo:

Aria → Acqua → Suolo → Aria → …

In altre parole, gli equilibri chimici alla base dello sviluppo di uno dei tre comparti influenzano tutti gli altri. Questo vuol dire che un contaminante immesso in atmosfera dall’attività antropica può ricadere al suolo attraverso le piogge; dal suolo può raggiungere le acque di falda mediante lisciviazione; da queste, infine, può arrivare ai fiumi ed al mare. Durante tutto questo percorso, il contaminante può entrare a contatto con la biosfera, ed in particolare con l’uomo, attraverso la catena alimentare con conseguenze più o meno drammatiche a seconda del livello di tossicità del contaminante stesso.[2]

Acqua, suolo e aria sono “comparti ambientali” (Unsplash).

Cosa vuol dire risorsa non rinnovabile

In termini ambientali, una “risorsa” è una qualsiasi fonte o un qualsiasi mezzo atto al sostentamento della vita [2][3] Alla luce di questa definizione, si può dire che i comparti ambientali descritti nel paragrafo precedente sono utili “risorse” per tutti gli esseri viventi. Non è difficile intuire, infatti, che senza aria e senza acqua non potrebbe esistere la vita come noi la conosciamo, così come senza suolo non sarebbe possibile alcuna produzione alimentare. Sfruttare le risorse per il sostentamento della vita vuol dire usarle, da un lato, per migliorare la qualità dell’esistenza (per esempio, producendo l’energia necessaria per muoversi verso l’agognato luogo delle meritate vacanze), dall’altro, per produrre gli alimenti che servono per sopravvivere (in modo da poter lavorare e guadagnare abbastanza per poter andare nei luoghi vacanzieri anzidetti). In ogni caso, lo sfruttamento delle risorse ambientali comporta il consumo delle stesse con riduzione progressiva delle capacità di sostenere la vita. Per esempio, usare acqua dolce nella lavatrice sottrae questa risorsa all’alimentazione; coltivare i campi per produrre alimenti diminuisce la qualità dei suoli (laddove il concetto di qualità è di tipo positivo dal momento che ci si riferisce ad un insieme di proprietà che consentono l’utilizzo dei suoli ai fini della produzione alimentare). Il significato di rinnovabile si riconduce alla capacità della risorsa utilizzata (e, di conseguenza, consumata) di rigenerarsi in modo da consentirne un uso costante nel tempo.[2][3] Questa visione di rinnovabile, tuttavia, è troppo generica perché non tiene conto del fatto che tutti i comparti ambientali sono rinnovabili su scale temporali che vanno molto oltre il tempo di vita medio degli esseri umani. Perché una risorsa possa essere considerata rinnovabile e quindi utile al sostentamento della vita, è necessario che il tempo necessario per la sua rigenerazione sia almeno confrontabile con quello medio della vita umana. Per questo motivo, si può affermare che i comparti ambientali anzidetti, in grado di rigenerarsi in tempi molto più lunghi della vita media umana, sono delle risorse non rinnovabili.

Cos’è la sostenibilità

Sostenibilità è un termine usato a livello scientifico con diversi significati a seconda del contesto in cui viene usato. In particolare, in campo agricolo, sostenibilità si riferisce alla capacità di un sistema a mantenere la propria produttività costante, indipendentemente dal grado di alterazione a cui il sistema stesso è sottoposto.[3] Alla luce di questa definizione, si può intuire che l’attività agricola in toto, ovvero anche quella ritenuta a impatto nullo come l’agricoltura biologica, ha un forte effetto sui suoli e sui diversi comparti ambientali. La lavorazione meccanica dei suoli, per esempio, se da un lato ne migliora l’ossigenazione e la strutturazione, dall’altro li rende più facilmente erodibili; le piante che assumono nutrienti durante le diverse fasi della germinazione e della crescita li sottraggono al suolo diminuendone, così, la fertilità se tali nutrienti non vengono opportunamente restituiti al suolo mediante fertilizzazione; l’irrigazione, necessaria per consentire la produzione vegetale, sottrae acqua potabile necessaria alla sopravvivenza umana; l’attività zootecnica oltre a sfruttare suolo (per la costruzione delle stalle e l’approvvigionamento alimentare degli animali) è associata anche alla contaminazione atmosferica in quanto gli animali producono gas serra; e potrei continuare. La conservazione delle risorse non rinnovabili passa necessariamente attraverso l’uso di pratiche agricole sostenibili quali, per esempio, quelle che limitano l’uso massivo di fertilizzanti inorganici favorendo l’applicazione di fertilizzanti organici; l’uso di tecniche colturali che limitano la produzione di gas serra (per esempio il minimum tillage e la semina diretta su terreno non lavorato) o il consumo di acqua potabile (per esempio la pacciamatura); la gestione integrata del suolo attraverso la lotta alla desertificazione e la corretta gestione dei suoli destinati sia alla produzione alimentare che energetica.[4][5][6]

La biodiversità è definita come «la variabilità tra gli organismi viventi all’interno di una singola specie, fra specie diverse e tra ecosistemi» (Unsplash).

Cosa significa biodiversità

L’enciclopedia Treccani definisce la biodiversità come «la variabilità tra gli organismi viventi all’interno di una singola specie, fra specie diverse e tra ecosistemi». In effetti il termine “biodiversità”, di cui tanti oggi abusano, è molto complesso e per spiegarlo provo ad usare delle metafore. Immaginiamo un condominio in un palazzo di 5 piani (sistema A) con due appartamenti per piano; ogni singolo appartamento può essere considerato come un piccolo ecosistema autonomo. Gli abitanti di ogni appartamento rappresentano la biodiversità dell’ecosistema/appartamento. Essi dormono, si svegliano, fanno colazione, pranzano, cenano e comprano tutto ciò di cui hanno bisogno. Un giorno il singolo proprietario di un appartamento che vive da solo nel suo ecosistema/bilocale, decide di fare un dolce ma si accorge di aver finito lo zucchero ed è troppo tardi per trovare un negozio aperto. Cosa fa? Esce dal proprio ecosistema/appartamento e suona all’ecosistema/appartamento vicino. Quest’ultimo è un ecosistema/quadrilocale in cui possono vivere comodamente 4 persone. La biodiversità dell’ecosistema/bilocale è inferiore in termini numerici rispetto a quella dell’ecosistema/quadrilocale. La maggiore disponibilità di spazio consente una maggiore biodiversità. Tuttavia, i due ecosistemi autonomi interagiscono tra loro quando è necessario per permettere la sopravvivenza (nel nostro caso mediante lo scambio di zucchero) degli organismi viventi che lo occupano (potremmo dire che occupano le due diverse nicchie ecologiche). Una volta evidenziato che gli organismi viventi possono sopravvivere grazie alla interazione tra gli ecosistemi confinanti, andiamo oltre. Il numero di componenti medio negli ecosistemi/appartamento è, diciamo, 4; ne viene che la popolazione del condominio è di 40 persone.

La biodiversità può essere esemplificata come un insieme di edifici diversi e dei loro abitanti (Pixabay).

Cambiamo scenario: consideriamo lo stesso numero medio di persone per appartamento ma in un condominio di un palazzo di 10 piani (sistema B). Il numero totale di persone in questo nuovo sistema è 80. Possiamo dire che la biodiversità (intesa come numero di persone) del sistema B è maggiore di quella del sistema A. Supponiamo ora che i due palazzi (ovvero sistema A e sistema B) siano costruiti in uno spazio in cui sia presente un termitaio (sistema C). Il termitaio è abitato da, diciamo, 10000 termiti. Possiamo dire che la biodiversità (sempre intesa come numero di individui per ogni sistema) varia nell’ordine sistema C > sistema B > sistema A. Tuttavia, la popolazione dei sistemi A e B è fatta da persone appartenenti alla stessa specie, ovvero umani (indichiamoli come sistema U, per semplicità), per cui possiamo dire che la biodiversità del termitaio è di gran lunga maggiore di quella degli umani nei due condomini appena citati, ovvero sistema C > sistema U. Facciamo, ora, un passo avanti e assumiamo che nel terreno dove sorgono i condomini ed il termitaio ci sia anche un fiume (sistema D) in cui mediamente vivono non meno di 500 pesci. Possiamo dire che la biodiversità (ancora intesa come numero di individui diversi) nei due ecosistemi suolo e acqua varia come sistema C > sistema D > sistema U. Tuttavia, se raggruppiamo i sistemi C ed U in base al fatto che sono entrambi terrestri (indichiamo i due messi insieme come sistema T), ne viene che sistema T > sistema D. Ma nel fiume, così come sulla terra, non “abitano” soltanto pesci o termiti o umani. Ci sono anche piante, uccelli, insetti, e altre moltitudini di micro, meso e macro organismi. È l’insieme di tutti questi esseri viventi, in grado di interagire tra loro con modalità differenti (per esempio in modo simbiotico o parassitario), a costituire la biodiversità.[7] L’esempio fatto evidenzia che la biodiversità si riferisce non solo alle specie viventi in un dato ecosistema, ma anche alla diversificazione degli ecosistemi stessi che sono in grado di interagire simbioticamente, e quindi sopravvivere, grazie alle interazioni tra loro. L’importanza della biodiversità risiede nel fatto che viene assicurato l’equilibrio dinamico della biosfera.[8] In particolare, maggiore è la biodiversità e maggiore è la probabilità che venga assicurata la continuità della vita nel caso in cui alterazioni ambientali sconvolgano gli ecosistemi.[8] In altre parole, se l’impatto di un meteorite sulla Terra comporta l’estinzione di una certa specie (come i dinosauri), la nicchia ecologica lasciata libera dalla specie estinta viene occupata da altre forme di vita e la vita, in senso generale, è, in ogni caso, in grado di continuare.[8]

L’agricoltura ha un inevitabile impatto sul suolo (Pixabay).

Agricoltura e biodiversità

Alla luce di quanto detto fino ad ora è lecito chiedersi quale sia il ruolo dell’agricoltura in tutte le sue forme nello sviluppo della biodiversità. È stato già evidenziato che tutte le pratiche agricole hanno un forte impatto sui diversi comparti ambientali alterandone le caratteristiche e rendendoli inadatti al sostentamento della vita se non vengono applicate opportune regole per la conservazione degli stessi.[4][5][6] Nella fattispecie, l’attività agricola necessita di ampi spazi nei quali poter coltivare le piante ad uso alimentare. I grandi spazi si ottengono solo attraverso il disboscamento. La semplice conversione di uno spazio da foresta a campo agricolo comporta non solo un aumento netto di anidride carbonica,[2] ovvero un gas serra, nell’atmosfera (quindi incremento dell’inquinamento del comparto aria), ma anche un cambiamento nella tipologia di micro, meso e macro fauna che è in grado di sopravvivere in quel luogo.[2] Faccio un esempio molto semplice: in un bosco vivono i gufi; se viene attuato il disboscamento per convertire il bosco in spazio arabile, si elimina l’habitat dei gufi che, di conseguenza, spariscono da quell’area. Al posto dei gufi subentrerà un’altra tipologia di uccelli, per esempio i corvi, che sopravvivono “predando” le colture che gli umani usano per la loro produzione alimentare. I gufi sono predatori naturali di topi ed altri piccoli animali. Questi ultimi, in assenza dei loro predatori, tenderanno a proliferare incrementando il loro numero. Come si arguisce da questo esempio banale, la conversione di uno spazio da bosco a campo agricolo comporta la sparizione di un certo tipo di esseri viventi e la comparsa di altri animali più adatti a vivere nel nuovo ambiente. Il discorso che ho fatto sui gufi, i corvi ed i topi si applica anche alla biomassa microbica dei suoli che, come gli animali anzidetti, contribuisce alla biodiversità del sistema agricolo. Tutto questo, naturalmente, è valido se guardiamo solo alla fauna. Se guardiamo alle specie vegetali, l’attività agricola (e, si badi bene, sto parlando di tutte le tipologie di agricoltura) comporta una drastica riduzione della biodiversità vegetale. Infatti le aree boschive sono molto ricche di specie vegetali di ogni tipo, in grado di vivere in simbiosi tra loro o parassitando altre specie vegetali. Se vogliamo produrre mega litri di olio extra vergine di oliva dalla varietà Biancolilla da esportare in tutto il mondo, abbiamo bisogno solo di ulivi che appartengono alla cultivar che ci interessa. La massimizzazione della produzione, inoltre, comporta la necessità di eliminare tutte le piante “parassite” in grado di competere con quelle di interesse per l’assorbimento dei nutrienti. In altre parole, l’attività agricola comporta una alterazione della biodiversità faunistica (micro, meso e macro) nel senso che ad una diminuzione del numero di specie viventi rispetto a quelle presenti nelle zone vergini corrisponde anche la colonizzazione del nuovo habitat da parte di altre specie adatte alla sopravvivenza negli spazi destinati all’agricoltura. Per altri versi, sotto il profilo della biodiversità vegetale, le monocolture sostituiscono l’enorme varietà biologica che caratterizza le aree boschive/forestali.

Campi di colza: l’agricoltura comporta una alterazione della biodiversità (Pixabay).

Da tutto quanto detto si capisce che è possibile distinguere tra biodiversità forestale/boschiva e biodiversità agricola (in questa sede tralascio gli altri tipi di biodiversità come quella aerea e acquatica che sono fuori contesto). La prima riceve un rapido decremento nel cambio di destinazione d’uso di un suolo (da forestale/boschivo a coltivato). Tuttavia, la biodiversità agricola, legata alla diversificazione delle specie viventi adatte alla vita in un ambiente “antropizzato”, dipende fortemente dal tipo di tecniche agricole utilizzate.[9][10][11][12] Infatti le pratiche intensive (intese come quelle che non guardano alla salvaguardia dell’ambiente ma solo alla produttività economica) portano ad una riduzione della biodiversità (dal 10 al 30%) rispetto a quella che si misura quando si fa uso di pratiche sostenibili.[9][10][11][12] Dal momento che è stato evidenziato che la salubrità alimentare è direttamente correlata alla biodiversità agricola,[13][14] da qualche anno tutte le agenzie internazionali spingono per l’applicazione di pratiche agricole sostenibili.[13][14][15] Queste ultime, quindi, oltre a consentire la conservazione delle risorse non rinnovabili come definite in precedenza, consentono anche la salvaguardia della biodiversità. Quest’ultima può essere a tutti gli effetti considerata anch’essa come una risorsa non rinnovabile (esattamente come suolo, aria ed acqua) da proteggere e conservare per il miglioramento della qualità della vita umana.

Cosa sono gli “organismi geneticamente modificati” o OGM

Esistono due aspetti distinti che devono essere presi in considerazione per definire il significato di “organismo geneticamente modificato”. Da un lato abbiamo l’approccio scientifico che si basa sui fatti, dall’altro abbiamo l’approccio politico che non tiene conto dei fatti ma solo dell’umore degli elettori e delle convenienze elettorali. Insomma, l’approccio politico alla definizione di OGM è di carattere culturale, piuttosto che reale.[16] Ma andiamo con ordine.

Le modifiche genetiche per la scienza

Charles Darwin

Fin da quando Darwin ha posto le basi della teoria dell’evoluzione è apparso chiaro, ed è diventato progressivamente sempre più evidente sotto il profilo sperimentale, che tutti gli organismi viventi hanno avuto origine da un progenitore comune che oggi noi chiamiamo LUCA, ovvero “Last universal common ancestor”, che altro non è che il famoso brodo primordiale nel quale si sono realizzate tutte le condizioni chimico fisiche per la formazione delle protocellule e lo sviluppo del metabolismo che caratterizza tutti gli esseri viventi.[17] Solo l’evoluzione, associata all’adattamento alle condizioni ambientali, dal progenitore comune riesce a spiegare la similitudine tra il nostro patrimonio genetico e quello di tanti altri organismi viventi. Per esempio, oltre il 98% di similitudine esiste tra il DNA umano e quello degli scimpanzé, oltre il 90% di affinità esiste tra il DNA umano e quello dei topi mentre oltre il 50% di somiglianza accomuna il nostro DNA a quello delle piante.[16] La differenziazione genetica avviene in modo casuale per effetto di errori imprevedibili durante i processi di replicazione del DNA. La moltitudine di organismi che viene così generata (quella che in precedenza è stata identificata col termine di “biodiversità”) è fatta da individui che sotto la spinta della pressione ambientale possono soccombere oppure sopravvivere. In quest’ultimo caso, il patrimonio genetico viene trasmesso alle generazioni successive. Nel corso di milioni di anni, la differenziazione genetica ha prodotto l’insieme di organismi viventi (dai microorganismi all’uomo) che oggi siamo abituati a conoscere. In definitiva, tutti noi siamo il prodotto di modificazioni genetiche (ovvero alterazioni imprevedibili del DNA) che ci consentono di occupare delle ben precise nicchie ecologiche nelle quali siamo in grado di sopravvivere.[18] Le modifiche genetiche possono essere indotte anche in modo mirato. Per esempio, fin da quando 10 000 anni fa l’uomo è passato dalla fase nomade di caccia/raccolta a quella stanziale di carattere prevalentemente agricolo,[19] ha tentato, tra successi ed insuccessi, di modificare le caratteristiche genetiche dei vegetali e degli animali in modo da aumentare la produttività agricola dei primi e rendere più docili i secondi. In entrambi i casi, lo scopo è sempre stata la massimizzazione della produzione alimentare così da sfamare un numero sempre più ampio (attualmente in fase di crescita esponenziale) di esseri umani. In assenza di conoscenze specifiche, le modifiche genetiche mirate venivano indotte per tentativi ed errori attraverso l’incrocio di organismi aventi ognuno una o più delle caratteristiche desiderate. In questo modo era possibile ottenere piante “domestiche” in grado di resistere a certe particolari patologie a cui non erano soggette piante selvatiche e meno utili sotto l’aspetto alimentare. Allo stesso modo, era possibile selezionare animali da latte in grado di produrre questo alimento in modo continuativo o animali da caccia con specifiche caratteristiche morfologiche tali da renderli adatti per le diverse tipologie di caccia. La progressione delle conoscenze ha condotto alla comprensione dei meccanismi biochimici alla base dell’ereditarietà genetica cosicché oggi è possibile operare modifiche genetiche con una possibilità di errore di gran lunga inferiore rispetto a quella associata ai tentativi di incrocio delle vecchie pratiche agricole/zootecniche. La nuove tecniche di ingegneria genetica consentono, infatti, di modificare il DNA di una specie vegetale variando unicamente i geni responsabili di certe particolari caratteristiche.[20] In questo modo si ottengono, in tempi molto più rapidi rispetto alle pratiche convenzionali, piante con proprietà nutrizionali o meccanismi di difesa di gran lunga superiori rispetto a quelle cosiddette tradizionali.[16] Un esempio tra tutti è il famoso “golden rice”:[21] si tratta di un riso modificato geneticamente capace di produrre, come metabolita secondario, il β-carotene, ovvero il precursore della vitamina A la cui carenza è associata a inibizione della crescita, deformazione e fragilità delle ossa/e modifiche delle strutture epiteliali e degli organi riproduttivi.[22] La carenza di vitamina A si ottiene solo per deficit nutrizionali in quelle popolazioni che non hanno accesso a fonti alimentari in grado di fornire i precursori della suddetta vitamina. È il caso, per esempio, delle popolazioni orientali (India in testa) la cui alimentazione è prevalentemente basata sull’uso del riso. La sostituzione del riso tradizionale col riso golden consente di superare i problemi nutrizionali di cui si accennava.

Chicchi di “golden rice” (a destra) a confronto con riso comune (International Rice Research Institute, CC-BY 2.0).

Le modifiche genetiche per la politica e l’opinione comune

È stato evidenziato come, sotto l’aspetto scientifico, tutti gli esseri viventi possano essere considerati come organismi geneticamente modificati perché derivati da processi evolutivi durante i quali piccole variazioni genetiche hanno consentito l’adattamento (e, di conseguenza, la sopravvivenza) nelle condizioni più disparate. È stato anche puntualizzato come il progresso tecnologico in ambito agricolo consenta oggi di effettuare modifiche genetiche mirate ed in tempi brevi in modo da ottimizzare la produttività agricola. I prodotti agricoli selezionati mediante ingegneria genetica non vengono utilizzati o immessi in commercio a cuor leggero, ma subiscono una serie di controlli molto minuziosi in modo da rilevare ogni possibile effetto collaterale sulla salute umana.[16] Nonostante la “naturalità” (nel senso comune del termine) delle modifiche genetiche e gli innumerevoli controlli cui i prodotti modificati geneticamente sono sottoposti, la politica, che – come già evidenziato – segue gli umori degli elettori, cerca di opporsi in tutti i modi agli OGM. La prima direttiva Europea 90/220/CEE sugli OGM stabilisce al comma 2 dell’articolo 2 che è «organismo geneticamente modificato (OGM), un organismo il cui materiale genetico è stato modificato in modo diverso da quanto si verifica in natura con l’accoppiamento e/o la ricombinazione genetica naturale»,[23] laddove viene preso in considerazione il concetto di “natura” che, come evidenziato in molta letteratura, è solo ed esclusivamente di carattere culturale.[16][24] I processi tecnologici mirati alle modifiche genetiche per il miglioramento delle caratteristiche vegetali sono in tutto e per tutto simili, in termini biochimici, a quanto accade “naturalmente”. La differenza che una certa politica vuole vedere è solo nel procedimento utilizzato. In questo modo una modifica genetica ottenuta per tentativi ed errori mediante innesti non porta, normativamente, ad un OGM, mentre un organismo ottenuto mediante la tecnica del DNA ricombinante è considerato, per legge, un OGM. Si deve, quindi, puntualizzare che, sotto l’aspetto scientifico, questa differenziazione normativa è completamente priva di significato e potrebbe essere legata unicamente ad una politica protezionistica delle aziende di prodotti fitosanitari di cui il vecchio continente, e l’Italia in particolare, è abbastanza ricco.[16][25][26] In effetti, come riportato in una intervista alla senatrice Elena Cattaneo su Linkiesta [24], i maggiori avversari, in Italia, dei prodotti OGM sono proprio le aziende che producono fitofarmaci[26] le quali vedrebbero ridurre i propri introiti dalla introduzione in agricoltura delle piante OGM (nel prossimo paragrafo si discuterà brevemente dei possibili vantaggi/svantaggi dell’uso agricolo degli OGM). Ma quale è il ruolo giocato dalle popolazioni Europee nell’indirizzare la politica dell’Unione e degli stati membri? In realtà bisogna dire che i cittadini dell’Unione Europea non sono adeguatamente informati sull’aspetto scientifico degli OGM e risentono in gran parte delle leggende e dei miti propagandati ad arte da gente di spettacolo[27] e da persone che hanno mitizzato i sapori delle epoche andate.[28] Tra questi miti sono da ricordare quello delle biotecnologie contro natura, della alterazione del DNA umano per ingestione di piante OGM, della diffusione della resistenza agli antibiotici con conseguente incremento nella difficoltà a resistere ad alcune malattie, della riduzione della biodiversità (di cui si discuterà più avanti) e così via cantando.[29] La scarsa preparazione scientifica associata ai miti anzidetti fa in modo che il cittadino EU prema sui governi affinché venga limitato l’uso di organismi geneticamente modificati in agricoltura. I governi colgono la palla al balzo e, per non perdere consensi, seguono l’umore del “popolo” abusando di un principio di precauzione che, come si intuisce da quanto scritto fino ad ora e come si comprenderà dalla lettura dei paragrafi seguenti, non ha alcun senso.

Presidio di attivisti anti–OGM a Badingen, Germania (Commons).

Agricoltura ed OGM

Al momento attuale l’uso di organismi geneticamente modificati in agricoltura è vietato in quasi tutta Europa. Solo Spagna e Portogallo hanno introdotto coltivazioni di mais OGM.[30] Tuttavia, la ascientificità delle proibizioni normative in atto sia in Europa che in tantissimi paesi del globo terrestre è supportata dalla pubblicazione di numerosi studi che evidenziano l’efficacia economica ed ambientale nell’uso agricolo di piante geneticamente modificate. In Cina, per esempio, la coltivazione di cotone OGM (quello che viene indicato come “cotone Bt”, ovvero modificato geneticamente con il gene del Bacillus thuringensis inserito nel vegetale per fargli produrre una tossina che lo rende resistente ai parassiti) ha portato benefici sia economici che ambientali. Infatti, studi condotti per la valutazione a breve[31] e lungo termine [32] del cotone Bt sulla società Cinese dimostrano non solo che gli agricoltori che hanno introdotto questa pianta nella loro produzione hanno avuto un incremento di guadagni economici, ma hanno anche operato una riduzione nella quantità di fitofarmaci, dannosi per l’ambiente, usati nella loro pratica agricola. Il cotone Bt ha apportato benefici anche agli agricoltori Indiani;[33][34][35] inoltre, impatti positivi, sia economici che ambientali, si sono avuti anche in alcuni paesi del Sud America (Brasile, Argentina e Paraguay) e negli Stati Uniti[36][37][38] a seguito dell’introduzione della soia OGM. Nonostante la grande massa di dati sperimentali che attestano della positività dell’uso in agricoltura di piante OGM, un lavoro molto recente pubblicato su Science Advances[39] si pone in controtendenza rispetto a quanto finora riportato per gli Stati Uniti. In particolare, gli autori dello studio[39] rivelano che mentre l’uso di mais OGM ha portato ad una riduzione della quantità di insetticidi ed erbicidi rispetto alla situazione antecedente al 1998, l’uso di soia OGM ha comportato sì una riduzione nella quantità di insetticidi, ma un incremento in quella di erbicidi. Gli autori del lavoro contestualizzano i loro dati evidenziando che l’incremento nell’uso di erbicidi conseguente alla coltivazione di soia OGM è dovuto all’aumento alla resistenza al glifosato[40] da parte delle erbe infestanti.

Applicazione di pesticida pre-semina o post-raccolto (Depositphotos).

Relazione tra organismi geneticamente modificati e biodiversità

Confezioni di Roundup® per giardinaggio/orticoltura sugli scaffali di un supermercato in Belgio (Depositphotos).

Lo studio in merito all’aumento alla resistenza al glifosato da parte delle erbe infestanti[39] è un interessante punto di partenza per discutere dell’argomento OGM–biodiversità, scopo del presente articolo. Infatti, il punto focale del predetto studio[39] è che l’aumento della resistenza al glifosato da parte delle erbe infestanti è conseguente alla coltivazione di soia “Roundup® resistant”. Il Roundup® è un fitofarmaco a base di glifosato,[40] la soia Roundup® resistant è un vegetale che non subisce danni da parte del glifosato. Nel momento in cui la soia Roundup® resistant viene coltivata, si può far gran uso di glifosato per eliminare le erbe infestanti che competono con la soia per l’assunzione di nutrienti dal suolo. La velocità di riproduzione e crescita delle erbe infestanti consente una variabilità genetica molto elevata. Questo significa che, per effetto degli errori casuali nella replicazione del DNA di cui si accennava in precedenza, è possibile che, tra le tante piantine infestanti, ne possa nascere qualcuna che sia resistente al glifosato. La conseguenza è che sono proprio queste ultime, più adatte a sopravvivere al citato erbicida, a prendere il sopravvento e a portare ad un uso sempre più massiccio di glifosato o di altre tipologie di erbicidi. In altre parole, la coltivazione della soia Roundup® resistant favorisce la biodiversità. Si tratta di un tipo di biodiversità economicamente dannosa e contro la quale bisogna applicare fitofarmaci dal forte impatto ambientale; ma il punto, per il momento, non è questo. Il punto è che l’uso di un sistema OGM favorisce la biodiversità vegetale strettamente detta. Una situazione analoga, sebbene più utile sotto l’aspetto economico per gli agricoltori che decidono di farne uso, si verifica in tutti quei paesi in cui non sono validi i brevetti sulle piante OGM. Per esempio in India il cotone Bt prodotto dalla Monsanto è stato utilizzato per generare 137 differenti ibridi ognuno con proprietà ben specifiche.[16] La possibilità di avere un numero di specie vegetali potenzialmente infinito mediante l’uso dell’ingegneria genetica ha consentito di salvaguardare tanti prodotti tipici[16] come, per esempio, la papaya nelle Hawaii[41] o il pomodoro San Marzano,[42] prodotto tipico Campano. In altre parole, sulla base delle definizioni oggettive date in merito a biodiversità e sistemi OGM, si può concludere che gli organismi geneticamente modificati possono essere considerati come risorsa per la biodiversità, piuttosto che come un problema come da più parti propagandato.[43][44][45]

Conclusioni

Gli organismi geneticamente modificati sono una risorsa per la biodiversità. Tuttavia, bisogna evidenziare che oltre ad una biodiversità economicamente conveniente, l’uso di coltivazioni OGM può generare una biodiversità vegetale contrastabile attraverso un uso progressivamente più massiccio di fitofarmaci potenzialmente dannosi per l’ambiente. Alla luce di questo, gli OGM devono essere condannati senza appello? La risposta è: certamente no. L’applicazione dell’ingegneria genetica all’agricoltura si inserisce nell’ambito di quella che è stata dichiarata in precedenza come “agricoltura sostenibile”. In altre parole, gli OGM devono essere pensati come complementari ai prodotti dell’agricoltura tradizionale (intensiva o meno) in modo da consentire la salvaguardia sia dei prodotti tipici che di tutte le risorse ambientali non rinnovabili dalla cui “distruzione”, alla luce dei meccanismi che avvengono in natura, gli unici ad uscire sconfitti sono solo gli esseri umani.

Riferimenti

- [1]argumentum ad populum (ricorso al popolo): è un tipo di fallacia di consistenza nella quale si afferma che una tesi sia corretta solo perché è sostenuta da un gran numero di persone.↩

- [2]Manahan, Stanley E. Environmental Chemistry, Ninth Edition. CRC Press, 2009. ISBN 978-1420059205↩

- [3]Conte, Pellegrino, Hans-Peter Schmidt e Giulia Cimò, “Research and Application of Biochar in Europe” (PDF) in Guo M., Z. He, M. Uchimiya (a cura di) Agricultural and Environmental Applications of Biochar: Advances and Barriers. Madison, WI: American Society of Agronomy, 2016.↩

- [4]“Buone pratiche per l’agricoltura” in Gelso — GEstione Locale per la SOstenibilità ambientale. ISPRA (Istituto Superiore per la Protezione e la Ricerca Ambientale). Web. <http://www.sinanet.isprambiente.it/gelso>↩

- [5]“Tecniche colturali a basso impatto ambientale” (PDF) in Crea. Consiglio per la Ricerca in agricoltura e l’analisi dell’Economia Agraria. <sito-entecra.it>↩

- [6]Briamonte, Lucia e Raffaella Pergamo (a cura di) I metodi di produzione sostenibile nel sistema agroalimentare (PDF). INEA (Istituto Nazionale di Economia Agraria), 2008. Ebook.↩

- [7]“Biodiversità” in ISPRA (Istituto Superiore per la Protezione e la Ricerca Ambientale). Web. <http://www.sinanet.isprambiente.it>↩

- [8]Leakey, Richard, Roger Lewin La sesta estinzione. La vita sulla terra e il futuro del genere umano. Torino: Bollati Boringhieri, 2015.↩

- [9]Liu, Chang, Meng Lu, Jun Cui e Bo Li “Effects of straw carbon input on carbon dynamics in agricultural soils: a meta-analysis” in Global Change Biology vol. 20, nº 5 (2014): 1366–1381.↩

- [10]Chappel, Liliana A. LaValle “Food security and biodiversity: can we have both? An agroecological analysis” in Agriculture and Human Values vol. 28, nº 1 (2011): 3–26.↩

- [11]Schneider, Manuel K., Gisela Lüscher, Felix Herzog “Gains to species diversity in organically farmed fields are not propagated at the farm level” in Nature Communications nº5 (2014).↩

- [12]Tuck, Sean L., Camilla Winqvist, Flávia Mota, Johan Ahnström, Lindsay A. Turnbull, Janne Bengtsson “Land-use intensity and the effects of organic farming on biodiversity: a hierarchical meta-analysis” in Journal of Applied Ecology vol. 51, nº 3 (2014): 746–755.↩

- [13]“La diversità biologica è fondamentale per l’agricoltura e la produzione alimentare.” FAO (Food and Agriculture Organization of the United Nations).↩

- [14]“Comunicazione della Commissione al Parlamento Europeo, al Consiglio, al Comitato Economico e Sociale Europeo e al Comitato delle Regioni” (PDF) Commissione Europea, 2010.↩

- [15]Esquinas-Alcàzar, José “Biodiversità e sicurezza alimentare— Il trattato internazionale sulle risorse fitogenetiche“. Archivio Storico Ministero dell’Interno.↩

- [16]Bressanini, Dario OGM tra leggende e realtà. Chi ha paura degli organismi geneticamente modificati? Bologna: Zanichelli, 2009. 978-8808062413↩

- [17]De Duve, Christian Alle origini della vita. Torino: Bollati Boringhieri, 2011.↩

- [18]“La biosfera e gli ecosistemi” (PDF), da Zanichelli Scuola <online.scuola.zanichelli.it>. Allegato a Saraceni, Silvia, Elvidio Lupia Palmieri Scienze Integrate Bologna: Zanichelli, 2010.↩

- [19]Harari, Yuval Noah Da animali a Dèi. Milano: Bompiani, 2014. ISBN 978-8845275906↩

- [20]Baima, Simona, Giorgio Morelli “Gai geni ai semi” (PDF) Roma: INRAN, 2010. Ebook. ISBN 978-8896597002↩

- [21]Capocci, Mauro “golden rice” in Enciclopedia della Scienza e della Tecnica. Roma: Treccani, 2008. Web.↩

- [22]Manuale MSD Merck Sharp & Dohme Corp., Web.↩

- [23]“Direttiva del Consiglio del 23 aprile 1990 sull’emissione deliberata nell’ambiente di organismi geneticamente modificati (90/200/CEE)”↩

- [24]Fuso, Silvano Naturale = Buono? Roma: Carocci Editore, 2016. ISBN 978-8843079230↩

- [25]Baratta, Lidia “Perché gli OGM fanno paura” Linkiesta, 11 Ott. 2015. Web.↩

- [26]“Elenco delle imprese produttrici di prodotti fitosanitari“.↩

- [27]“Passaparola — OGM: tolleranza zero” Il Blog di Beppe Grillo, 22 Lug. 2013. Web.↩

- [28]“Gli OGM in Europa” Slow Food. Web.↩

- [29]OGM in agricoltura: le risposte alle domande più frequenti (PDF) Regione Lombardia — Consiglio Scientifico per le Biotecnologie in Agricoltura, Luglio 2004. Ebook.↩

- [30]“OGM in crescita, ma solo in 28 Paesi del mondo: mappa e classifica 2014” GreenBiz, 29 gennaio 2015. Web.↩

- [31]Pray & Ma “Impact of BT cotton in China” World Development, 29 (2001): 813-825 (PDF).↩

- [32]Qiao, “Fifteen Years of Bt Cotton in China: The Economic Impact and its Dynamics” World Development, 70 (2015): 177-185.↩

- [33]Qaim “Bt Cotton in India: Field Trial Results and Economic Projections” World Development, 31 (2003): 2115–2127↩

- [34]Krishna & Qaim “Bt cotton and sustainability of pesticide reduction in India” Agricultural Systems, 107 (2012): 47-55.↩

- [35]Subramanian & Qaim “Village-wide effects of agricultural biotechnology: the case of Bt cotton in India” World Development, 37 (2008): 256-267.↩

- [36]van de Vield et al. “GM-Relates Sustainability: Agro–Ecological Impacts, Risks and Opportunities of Soy Production in Argentina and Brasil” (PDF) in Researchgate, 2009. Web↩

- [37]Brookes, Graham, Peter Barfoot “GM Crops: The Global Economic and Environmental Impact – The First Nine Years 1996-2004” AgBioForum Vol. 8, nº2–3 (2005).↩

- [38]Bonny “Genetically modified glyphosate-tolerant soybean in the USA: adoption factors, impacts and prospects. A review” Agronomy for Sustainable Development, vol 28, nº1 (2008): 21-32.↩

- [39]Perry & al., 2016, “Genetically engineered crops and pesticide use in U.S. maize and soybeans” Science Advances, vol 2, nº8 (2016).↩

- [40]Conte, Pellegrino “Il glifosato: pericolo per l’ambiente ma innocuo per l’uomo?” Laputa. 19 Mar. 2016. Web.↩

- [41]“Papayas” GMO Compass, 27 Nov. 2006. Web.↩

- [42]Gianessi, Leonard, Sujatha Sankula, Nathan Reigner “Tomato – Virus-Resistant Case Study” (PDF) National Center for Food and Agricultural Policy <ncfap.org> (2003).↩

- [43]“Facciamo chiarezza sugli OGM” (PDF) – Civielle, 2014.↩

- [44]“Current knowledge of the impacts of ganetically modified organisms on biodiversity and human health” (PDF) IUCN World Conservation Union, 2007.↩

- [45]Garcia & Altieri “Transgenic Crops: Implications for Biodiversity and Sustainable Agriculture” (PDF) in Agroecology in Action <agroeco.org>, 2010.↩

L’approccio del risolvere un grande problema trovando le cose microscopiche che sono rotte ed aggiustarle è chiamato riduzionismo — se si vuole comprendere un sistema, bisogna scomporlo nelle parti che lo costituiscono. Il pensiero riduzionista ha dominato la scienza occidentale per secoli, aiutando l’occidente a tirarsi fuori dal pantano dell’età medievale. Il riduzionismo può essere una gran bella cosa. Essendo stato bambino all’epoca di Jonas Salk, sono immensamente felice di aver beneficiato di un prodotto della scienza riduzionista, ovveroil vaccino scoperto da lui (o da Albert Sabin, ma non ci addentriamo in questo argomento), invece di aver avuto un pediatra che facesse un rituale su me armato di ciondoli, feticci e interiora di capra per propiziarsi il demone della polio. Gli approcci riduzionisti alle scienze mediche hanno fornito vaccini, farmaci che bloccano fasi specifiche della replicazione virale e identificato precisamente quale parte di noi si guasta in moltissime malattie. È grazie al riduzionismo se, nel corso dell’ultimo secolo, la nostra aspettativa di vita è aumentata considerevolmente. Perciò, se si vuole comprendere la biologia del ciò che siamo […] l’approccio riduzionista fornisce regole del gioco piuttosto chiare: capire gli individuiche formano la società; capire gli organi che costituisconogli individui, le cellule che formano gli organi e, scendendo fino alle fondamenta dell’intero edificio, capire i geni che danno istruzioni alle cellule su cosa fare. Questa prospettiva ha dato luogo a un’orgia di ottimismo riduzionista nella forma del progetto di ricerca più dispendioso storia delle scienze naturali, il sequenziamento del genoma umano.

Robert M. Sapolsky

Era il 2005 quando Robert M. Sapolsky scriveva nell’introduzione al suo Monkeyluv: and other essays on our lives as animals (che nella traduzione italiana de I Timoni – Castelvecchi editori del 2014 suona così: L’uomo bestiale: come l’ambiente e i geni costruiscono la nostra identità) quanto ho appena riportato. Il suo elogio del riduzionismo è la base per evidenziare come ridurre il comportamento umano alla risultante lineare dei comportamenti dei geni contenuti nel DNA sia sbagliato. L’approccio più corretto è prendere in considerazione l’effetto combinato di geni ed ambiente. Insomma, usando un linguaggio più “pop”, la comprensione dell’uomo passa attraverso un approccio “olistico” che deve considerare tutto l’insieme, interno ed esterno, di ciò che caratterizza l’essere umano. Non sono un neurofisiologo né un osservatore del comportamento umano; non sono in grado di sostenere o controbattere le argomentazioni di Sapolsky nel suo campo. Per questo mi addentro nel campo che mi è più congeniale che è quello chimico. Indubbiamente scomporre un sistema complesso nelle sue singole componenti ha consentito l’enorme sviluppo scientifico degli ultimi 4 secoli. Se oggi sappiamo quante sono le forze che tengono insieme i nostri atomi e, nel loro complesso, l’insieme di atomi alla superficie terrestre, è perché qualcuno è andato a smontare la materia ed ha visto da cosa è composta.[1] L’approccio riduzionista è quello che ha permesso lo sviluppo di tecniche analitiche come la cromatografia in fase liquida o quella in fase gassosa; la risonanza magnetica nucleare ad alta e bassa risoluzione, e tutta una serie di tecniche oggi riconosciute come incomparabili per la valutazione della qualità degli alimenti o per la loro tracciabilità (questo tanto per stimolare la corda più populista di chi si preoccupa di sapere se l’olio extravergine che usa è tunisino o viene fatto raccogliendo le olive dietro casa).[2] Tuttavia, sebbene fin dagli albori della scienza ai giorni nostri ha prevalso l’idea che le proprietà di tutti i sistemi fossero comprensibili solo sulla base di una loro scomposizione nelle diverse componenti elementari e che la somma delle proprietà di ciascuna risultasse, in qualche modo, nelle proprietà dell’intero sistema, appare chiaro, oggi, che non è così. Usando un linguaggio matematico, si può dire che le proprietà dei sistemi complessi non sono una combinazione lineare delle proprietà delle singole componenti, quanto piuttosto la risultante delle loro interazioni non lineari.[3] Le eventuali relazioni lineari debbono essere considerate solo come caso particolare di quello più generale che si inquadra nella già citata relazione non lineare.

Henri Le Châtelier, chimico (1850-1936).

Un esempio abbastanza banale è il principio di Le Châtelier: quando un sistema all’equilibrio chimico viene perturbato per effetto di un’azione esterna, il sistema reagisce in maniera da ridurre o annullare la sollecitazione stessa ristabilendo l’equilibrio.[4] Per esemplificare questa definizione prendiamo un composto A che, in una soluzione, è in equilibrio con il composto B secondo l’equazione: nA = mB dove n e m sono i coefficienti stechiometrici. Il sistema sotto osservazione contiene due componenti (A e B) che interagiscono tra loro in modo tale che aumentando la concentrazione del reagente A, la reazione si sposta a destra producendo una maggiore quantità di prodotto B. Allo stesso modo introducendo una certa quantità di B, la reazione si sposta verso sinistra portando alla formazione di A. Pur sapendo che il sistema è fatto da due componenti le cui proprietà possono essere studiate indipendentemente le une dalle altre, non possiamo dire che il comportamento del sistema nella sua totalità sia dato dalla combinazione lineare della concentrazione delle singole componenti (la concentrazione è una proprietà intensiva[5]). Infatti, è possibile dimostrare che la relazione che lega la concentrazione di A a quella di B all’equilibrio chimico è: [B]^m = k x [A]^n dove k è comunemente indicata come costante di equilibrio (la x indica semplicemente l’operazione di moltiplicazione). Possiamo concludere, da questo semplice esempio, che l’equilibrio chimico (croce di tutti gli studenti e delizia di tutti i docenti) non è altro che una proprietà delle soluzioni, emergente dalle interazioni non lineari delle proprietà (in questo caso la concentrazione) delle singole componenti della soluzione. La storia della scienza (e, nella fattispecie, della chimica in particolare) è ricca di esempi di questo tipo. Volendo considerare un caso più complesso si può citare l’allosterismo: «L’allosterismo rappresenta una delle modalità di regolazione della funzione di alcune proteine, di solito oligomeriche, […]; fra queste si ricordano l’emoglobina e numerosi enzimi».[6] Originariamente proposta da Jaques Monod,[7] la regolazione allosterica delle proteine consiste nel fatto che un piccolo metabolita si lega ad uno dei siti attivi della proteina modificandone la conformazione (ovvero la struttura tridimensionale) ed alterandone nel contempo le funzionalità (sia migliorandole, allosterismo positivo, che inibendole, allosterismo negativo).

(Isaac Webb/Commons CC-BY-SA 3.0)

- sito attivo;

- sito allosterico;

- substrato;

- inibitore;

- enzima.

- in assenza di inibitore, l’enzima (E) si lega al substrato (C).

- l’intervento dell’inibitore (D) modifica il sito attivo (A), l’enzima non è più in grado di legarsi al substrato: la reazione allosterica è negativa.

Schema esemplificativo di reazione allosterica negativa.

L’esempio più semplice è la regolazione allosterica positiva dell’emoglobina da parte della molecola di ossigeno. È noto che l’emoglobina è una proteina complessa costituita da quattro sub unità proteiche ognuna con un sito attivo che prende il nome di “gruppo eme”.[8] Quando una molecola di ossigeno si lega al gruppo eme di una delle sub unità, la conformazione di questa sub unità si modifica secondo una modalità che potrebbe essere vista come una mano che si chiude a pugno dopo aver afferrato un oggetto. Le modificazioni conformazionali della sub unità suddetta modificano quelle delle altre sub unità che appaiono, quindi, nella nuova situazione come delle mani più aperte pronte ad afferrare un nuovo oggetto. Grazie a queste modificazioni conformazionali, la seconda molecola di ossigeno è in grado di legarsi al secondo sito attivo più velocemente di quanto abbia fatto la prima molecola di ossigeno. A seguito di questa seconda interazione, le sub unità ancora libere subiscono delle ulteriori modificazioni conformazionali aprendosi ancora di più e permettendo ad una terza molecola di ossigeno di legarsi ancora più velocemente rispetto alle prime due. La terza molecola di ossigeno induce dei nuovi cambiamenti conformazionali nell’ultima sub unità libera cosicché essa riceve l’ultima molecola di ossigeno con una facilità ancora maggiore rispetto alle precedenti. Da un punto di vista matematico l’allosterismo dell’emoglobina non è descrivibile mediante una relazione lineare, bensì attraverso una sigmoidale[8]. Come nel caso dell’equilibrio chimico su descritto, anche l’allosterismo non può essere considerato semplicemente come la risultante di una combinazione lineare delle proprietà delle singole sub componenti di un enzima/proteina, quanto piuttosto come una proprietà emergente dalle loro interazioni non lineari. Tutta la chimica (dalla chimica organica, alla biochimica, alla chimica del suolo e così via) è ricca di sistemi complessi le cui proprietà emergono dalle interazioni tra le singole sub unità componenti. Come non ricordare, per esempio, la complessità del metabolismo in cui ogni singolo metabolita rappresenta solo un dente di un ingranaggio ben più complicato le cui caratteristiche non sono la somma di quelle dei singoli denti, ma da essi derivano. In questa ottica va inserito il concetto di vita vista come una proprietà che emerge dalle complesse interazioni occorrenti nei processi metabolici.[9]

…conoscere le proprietà delle tessere di un puzzle non aiuta a comprendere il disegno contenuto nel puzzle, se non si riesce ad inserire ogni singola tessera nella giusta posizione dello schema del gioco.

Qual è dunque l’importanza del riduzionismo nell’ottica scientifica attuale? Nato come «concezione epistemologica che tende a formulare concetti e linguaggio di una teoria scientifica nei termini di un’altra teoria considerata più fondamentale»,[10] il riduzionismo si è basato, a partire dal XVII secolo, “sull’ipotesi che tutta la realtà fisica possa essere in definitiva ‘ridotta’ (e spiegata) in termini di particelle materiali e dei loro movimenti”.[10] L’idea che tutta la realtà fenomenologica potesse essere spiegata solo sulla base delle conoscenze delle caratteristiche delle singole componenti microscopiche è stata superata solo nel XX secolo quando ci si è resi conto che conoscere le proprietà delle tessere di un puzzle non aiuta a comprendere il disegno contenuto nel puzzle, se non si riesce ad inserire ogni singola tessera nella giusta posizione dello schema del gioco. Da qui la rilettura in termini di proprietà emergenti di tutti i concetti scientifici come, per esempio, il principio di Le Châtelier precedentemente discusso. Il riduzionismo deve essere, quindi, considerato come un approccio che consente non solo di conoscere i singoli dettagli della realtà fisica fino alle dimensioni microscopiche, ma anche in grado di riporre le varie sub componenti della stessa nella giusta posizione rispetto a tutte le altre in modo da poter riprodurre con accuratezza le proprietà macroscopiche dell’intero sistema rappresentato dalla realtà osservata. In questa ottica il giudizio (secondo la mia lettura, negativo) di Sapolsky in merito alla dispendiosità del progetto di ricerca sul genoma umano mi lascia molto perplesso. È pur vero che la conoscenza del genoma non risponde a tutte le domande che ci possiamo porre in merito al comportamento umano, ma è anche vero che attribuire ai geni la responsabilità di ogni cosa è solo una trovata di un giornalismo di bassa lega che deve fare business e vendere un prodotto a un pubblico le cui conoscenze scientifiche sono mediamente basse. Si tratta dello stesso pubblico che ha necessità di trovare delle correlazioni di causalità laddove esistono solo relazioni di casualità come nel caso dell’omeopatia[11] e dell’autismo causato dai vaccini[12] Mi trovo, invece, molto d’accordo sull’idea dell’interazione corredo genetico/ambiente nello sviluppo del comportamento umano in quanto questo modo di pensare si inserisce molto bene nel modello di riduzionismo emergentista di cui si è discusso fino ad ora.

Riferimenti

- [1]Conte, Pellegrino “Il binario 9 e ¾ ovvero del perché non possiamo attraversare i muri come Harry Potter“. Laputa. 31-10-2015, Web.↩

- [2]Rocco, Anna, Salvatore Fanali. “Tecnologie per il miglioramento della qualità e della sicurezza degli alimenti.” Istituto di Metodologie Chimiche. Consiglio Nazionale delle Ricerche. Web.↩

- [3]Sapereaude, “Apologia del riduzionismo” Scienza di Frontiera. 8 Gen. 2012. Web.↩

- [4]“Principio di Le Châtelier” chimica–online.it. Web.↩

- [5]Longato, Bruno (PDF) “Le soluzioni” Dipartimento di Scienze Chimiche. Università degli studi di Padova. Web.↩

- [6]Stefani, Massimo, Niccolò Taddei. Percorsi di Biochimica. Zanichelli, 2012.↩

- [7]“Allosterìa” Enciclopedia Sapere.it↩

- [8]“Una proteina in azione: l’emoglobina” in Biochimica Zanichelli, 2003. ISBN: 88-08-07893-0↩

- [9]Luisi, Pier Luigi Sull’origine della vita e della biodiversità. Mondadori Università, 2013. ISBN 9788861842953↩

- [10]“riduzionismo” in Enciclopedia Treccani. Web.↩

- [11]Conte, Pellegrino “Omeopatia, una pratica esoterica senza fondamenti scientifici” Laputa, 7 Mag. 2016.↩

- [12]“Common Concerns“. Vaccine Safety. Centers for Disease Control and Prevention. <www.cdc.gov/vaccinesafety/concerns/autism.html>↩

Immagine copertina: skeeze/Pixabay.

Il contesto storico

10 (o 11, non si sa bene) Aprile 1755. Nasce a Meißen, in Germania, Samuel Hahnemann. Non tutti sanno di chi si tratti, ma basta una veloce ricerca in rete per scoprire che Samuel Hahnemann è colui che ha inventato l’omeopatia. La seconda metà del settecento e tutto l’ottocento hanno visto progressi scientifici e tecnologici senza pari; basti pensare che tra il 1777 ed il 1778 Lavoisier scopre il ruolo dell’ossigeno nella combustione e nella respirazione animale;[1] tra il 1773 ed il 1780 Priestley scopre il ruolo delle piante nel purificare l’aria contaminata da anidride carbonica;[1] nel 1775 Cavendish propone un esperimento per misurare la densità della Terra mentre nel 1784 scopre la composizione precisa dell’aria oltre a proporre una sintesi dell’acqua;[1] nel 1783 i fratelli Montgolfier realizzano il sogno dell’uomo: il volo con la mongolfiera;[2] nel 1800 Volta scopre la pila;[3] tra il 1802 ed il 1810, Dalton enuncia la legge delle proporzioni multiple, la legge delle pressioni parziali ed introduce la teoria atomica;[1] nel 1803 Berthollet dimostra “che il risultato di una trasformazione chimica è modificato dalle proporzioni relative delle sostanze messe a reagire, e dalle condizioni fisiche – temperatura, pressione, ecc. – in cui essa avviene”;[1] nel 1804 Trevithick inventa la locomotiva a vapore su rotaia;[4] tra il 1803 ed il 1824, Berzelius scopre il cerio, il selenio, il torio, isola il silicio, lo zirconio ed il tantalio e studia i composti del vanadio, oltre a formulare per primo la teoria dell’isomerismo;[1] nel 1828, Wöhler per primo dimostra come un composto organico, ovvero un composto implicato nella vita, possa essere ottenuto dalla trasformazione di un sale inorganico, ovvero non coinvolto nei processi vitali, contribuendo ad abbattere la teoria della “vis vitalis”[5] proposta dal suo maestro Berzelius;[1] tra il 1814 ed il 1841 Avogadro pubblica i suoi lavori in cui dimostra che “volumi uguali di gas diversi, alla stessa temperatura e pressione, contengono lo stesso numero di molecole”,[6],oltre ad elaborare teorie sulla densità dei gas e la costituzione della materia;[1] nel 1847, Semmelweis intuisce le cause della febbre puerperale e propone l’uso dell’ipoclorito di sodio per la disinfezione delle mani dei medici impegnati tra i reparti di ostetricia e di medicina legale;[7] intorno al 1860 Cannizzaro contribuisce a rafforzare le ipotesi di Avogadro, scopre che l’idrogeno è una molecola biatomica e pubblica la reazione di dismutazione della benzaldeide che oggi è conosciuta come “reazione di Cannizzaro”.[1]

In pratica, il periodo in cui Hahnemann svolge la sua attività di medico vede la nascita e lo sviluppo di teorie più o meno note, oggi ancora valide, molte attualmente inglobate in modelli di carattere più generale, altre del tutto scomparse. Tra queste ultime ricordiamo la teoria della “vis vitalis”[5] elaborata da Berzelius, con la quale si tentava di spiegare l’origine della vita e la teoria della generazione spontanea[8] che, nella prima metà del 1800, era sostenuta ancora da personalità come de Lamarck e Saint-Hilaire. Queste erano teorie valide nel contesto storico in cui furono sviluppate quando ancora non si sapeva dell’esistenza di forme di vita microscopiche e non si disponeva degli strumenti adatti per poterle riconoscere. La medicina era ancora agli albori come scienza e si basava essenzialmente sul fatto che le malattie erano intese come alterazioni degli equilibri tra i quattro umori (sangue, flemma, bile nera e bile gialla) e le quattro condizioni fisiche (caldo, freddo, umido e secco)[9] Il ritorno all’equilibrio poteva essere assicurato solo attraverso pratiche che oggi noi chiameremmo magiche: purghe, unguenti, emetici e salassi. Era anche il tempo in cui il metodo scientifico, basato sulla sperimentazione e la riproducibilità, veniva ampiamente applicato in molti rami della scienza sebbene, molte volte, con estrema rudimentalità (sia di esempio la storia di Semmelweis ostracizzato dalla comunità medica a causa delle sue osservazioni sperimentali[7]). Ed è stato proprio l’applicazione di un rudimentale metodo scientifico a portare Hahnemann all’elaborazione di quella che è indicata come “medicina omeopatica”.

3 – Farmacia omeopatica a Varanasi, India (foto: J. Royan/Commons CC-BY-SA 3.0).

Le origini dell’omeopatia

Nel tentativo di spiegare il significato di “malattia” e di “cura della malattia” in modo più efficace rispetto agli inefficienti riti magici che prevedevano purghe, unguenti, emetici e salassi, Hahnemann rielabora la teoria della “vis vitalis”[5] introducendo il concetto di malattia intesa come una alterazione dello stato di salute causato da un “miasma”.[10] Quest’ultimo viene considerato come una esalazione che altera il funzionamento della “vis vitalis” e, di conseguenza, le proprietà dell’organismo. Quando l’organismo tenta di opporsi spontaneamente all’aggressione del “miasma”, ottiene solo l’incremento della patologia. In altre parole, il “miasma” si identifica con una condizione progressivamente peggiorativa, non risolvibile spontaneamente, dello stato di salute.[10] Il “miasma”, inoltre, non agisce allo stesso modo su tutti gli organismi. Individui diversi sviluppano un tipo di malattia il cui percorso dipende dal loro personale modo di essere. In altre parole, la malattia è indipendente dall’ambiente e relativo invece alla costituzione interna dell’individuo. Da ciò nasce la necessità della cura soggettiva, non valida per tutti, individuata solo attraverso una indagine “olistica” che tenga conto dell’interazione della “vis vitalis” con tutte le componenti dell’organismo malato.

4 – La pianta della china (Cinchona calisaya), da Franz Eugen Köhler, Köhler’s Medizinal-Pflanzen, 1897.

A una tale conclusione Hahnemann giunge applicando su se stesso il metodo scientifico basato sulle osservazioni sperimentali. Infatti, per capire in che modo la corteccia dell’albero della china agisse nel riordinare il flusso della “vis vitalis” nell’organismo ammalato di malaria, egli si sottopone (da sano) ad una cura che prevede dosi progressivamente più elevate della predetta corteccia. All’aumentare delle dosi, Hahnemann osserva sintomi del tutto simili a quelli della malaria: debolezza, brividi e febbre.[9] Quindi, se un individuo sano, che assume un dato rimedio, rivela i sintomi della malattia che viene debellata quando lo stesso rimedio è assunto da un individuo malato, ne viene che il modo migliore per eliminare le cause dell’alterazione alla “vis vitalis”, riportando l’organismo alle sue funzioni originali, è quello del “chiodo scaccia chiodo”, ovvero il rimedio deve indurre la stessa malattia che si intende sconfiggere. Da qui il termine “omeopatia” per indicare “il simile cura il simile” contrapposto ad “allopatia” in cui la malattia viene combattuta con rimedi che si oppongono alla stessa. Inoltre, Hahnemann suggerisce che più bassa è la concentrazione del principio che viene assunto dal malato e migliore è la sua efficacia, contravvenendo a quelli che erano i principi basilari della farmacologia ben noti anche nel suo tempo.[9] In particolare, egli suggerisce che per “attivare” la “vis vitalis” del rimedio è necessario effettuare diluizioni successive utilizzando il metodo della “succussione”, ovvero lo scuotimento sistematico delle miscele seguendo dei criteri che oggi definiremmo magici.[9]

Il falso mito del riduzionismo scientifico

Oggi sappiamo che uno dei ruoli svolto dalla ventina di molecole ad azione antimalarica nella corteccia dell’albero della china è quello di inibire la sintesi di un enzima coinvolto nei processi di detossificazione del gruppo eme che si ottiene per effetto della “digestione” dell’emoglobina da parte dei parassiti che inducono la malaria. Infatti, il gruppo eme è tossico per questi parassiti. Essi dispongono di un enzima che distrugge l’eme rendendolo innocuo. Gli alcaloidi della corteccia dell’albero della china impediscono l’azione del predetto enzima e consentono all’eme di agire contro i parassiti stessi.[11]

La conoscenza del meccanismo di azione degli alcaloidi della corteccia della china è stata resa possibile da un approccio riduzionista, ovvero dalla considerazione che un qualsiasi complesso chimico (dalla roccia, ad un organismo monocellulare, fino all’uomo) è fatto dall’interazione di tante parti ognuna della quali ha una ben precisa funzione. Quindi, se vogliamo sapere come funziona un determinato metabolita, innanzitutto dobbiamo isolarlo e purificarlo. Una volta purificato ne individuiamo la struttura e ne comprendiamo il ruolo biologico sulla base del principio di relazione tra struttura chimica ed attività biologica: una molecola che ha una certa struttura chimica ha solo quella particolare funzione biologica. Una qualsiasi variazione strutturale (per esempio un cambiamento di isomeria) altera la funzione biologica della molecola che, di conseguenza, non è più in grado di assolvere al suo ruolo nell’organismo.

Solo chi non è troppo addentro a fatti scientifici, come spesso capita quando si interloquisce con pseudo filosofi che pensano di conoscere il mondo meglio di chiunque altro, ritiene che i processi di riduzione di un complesso alle sue componenti sia perdere di vista l’organismo in tutta la sua complessità. Le argomentazioni “olistiche” sostenute dai fautori dell’omeopatia si possono riassumere nella banale affermazione che le proprietà di un organismo vivente non sono date dalla somma delle singole componenti che lo caratterizzano, ma sono qualcosa di più. In altre parole, ancora più banalmente, secondo i fautori dell’omeopatia è sempre valida la regola che 2 + 2 > 4 (Figura 5). Questa è una fallacia logica (oltre che ignoranza scientifica) che può essere confutata molto semplicemente facendo l’esempio dello studio delle proprietà dell’acqua.

5 – Schema comparativo tra il metodo applicato dai fautori dell’omeopatia ed il metodo scientifico. Senza alcuna conoscenza di base, le proprietà dei sistemi complessi sembrano inconciliabili con le proprietà delle singole componenti. Il risultato sembra, quindi, che 2+2=10. In realtà, l’approfondimento delle proprietà chimico fisiche delle singole componenti, consente di spiegare la proprietà emergente dell’acqua (ovvero, per es., che il ghiaccio galleggia sull’acqua liquida) che non è racchiusa in nessuna delle singole componenti che contraddistingue la molecola. In definitiva, ogni singolo step conoscitivo corrisponde all’operazione (2 + 2 = 4). La somma totale delle conoscenze dà il risultato corretto di 10.

L’acqua è una molecola di formula H2O, ovvero è costituita da idrogeno ed ossigeno nel rapporto 2 : 1. L’idrogeno è un elemento della tavola periodica con numero atomico 1 e peso atomico di circa 1 u.m.a. (unità di massa atomica), l’ossigeno ha numero atomico 8 e peso atomico di circa 16 u.m.a. Queste informazioni, pur essendo basilari, non ci dicono assolutamente nulla in merito al ruolo svolto da idrogeno ed ossigeno nel modulare le proprietà dell’acqua. Per poter capire nei minimi dettagli il comportamento dell’acqua, abbiamo bisogno di un grado di conoscenza ulteriore. In altre parole abbiamo bisogno di sapere in che modo idrogeno ed ossigeno interagiscono tra loro. Per poterlo sapere abbiamo bisogno di introdurre gli orbitali atomici che si combinano a formare gli orbitali molecolari. Non è questa la sede per andare troppo nei dettagli. Basti sapere che l’utilizzo del formalismo degli orbitali molecolari consente di capire che la molecola dell’acqua ha una struttura tetraedrica in cui due vertici sono occupati dai due atomi di idrogeno ed altri due dai doppietti solitari dell’ossigeno. Il centro del tetraedro è occupato dall’ossigeno. Queste informazioni non sono ancora sufficienti a capire perché l’acqua ha il comportamento che noi conosciamo, ovvero perché, per esempio, il ghiaccio galleggia sull’acqua liquida. Il gradino di conoscenze successivo consiste nel capire in che modo le diverse molecole di acqua interagiscono tra di loro. Senza utilizzare troppi dettagli, si può dire che le molecole di acqua, ognuna occupante una certa porzione di spazio tridimensionale, si legano tra loro mediante legami ad idrogeno in modo tale da formare dei “clusters” (ovvero gruppi di molecole) fatti da tetraedri in cui una molecola di acqua centrale lega altre quattro molecole di acqua (via legami a idrogeno) disposte lungo i vertici di un tetraedro. Bastano queste informazioni a spiegare perché il ghiaccio galleggia? Non ancora. Abbiamo bisogno di un andare un gradino oltre le nostre conoscenze. Per poter spiegare la più bassa densità del ghiaccio rispetto all’acqua liquida, abbiamo bisogno di sapere quali sono le peculiarità del legame a idrogeno. Affinché un legame a idrogeno si possa formare, devono essere rispettati sia dei requisiti energetici che dei requisiti geometrici. Questi ultimi consistono nel fatto che il legame O-H (legame covalente) in una molecola di acqua deve essere allineato col legame H…O (legame a idrogeno) a formare un unico asse (geometria lineare del legame a idrogeno).[12] Quando l’acqua si raffredda, la geometria lineare si deve conservare. Questo implica che le diverse molecole di acqua si dispongono in posizioni ben precise allontanandosi le une dalle altre ed aumentando, di conseguenza, lo spazio tra di esse con diminuzione della densità. Il risultato finale di tutta questa conoscenza è che il ghiaccio galleggia sull’acqua liquida e per questo nel 1914 il Titanic,[13] non potendo violare il principio di incompenetrabilità dei corpi,[14] è affondato.

Come si evince dalla complessa spiegazione appena riportata (schematizzata nella Figura 5), da nessuna parte del ragionamento basato su modelli scientifici è riportato che 2 + 2 è diverso da 4. Anzi, le proprietà dell’acqua solo apparentemente sembrano essere un miracolo. Esse non sono altro che il risultato emergente dalla complessità delle proprietà chimico fisiche delle singole componenti della molecola in cui ogni livello di conoscenza corrisponde alla semplice operazione matematica (2 + 2 = 4). È l’assenza di conoscenze, associata alla convinzione che le spiegazioni scientifiche siano intuitive (mentre tutte le spiegazioni scientifiche sono contro intuitive), a generare i mostri pseudo–scientifici che nella fattispecie si identificano con l’omeopatia.

Il falso mito della memoria dell’acqua

Non è un caso che l’acqua sia stata usata come esempio per evidenziare le fallacie cognitive di chi pensa che l’omeopatia sia la panacea di ogni male. Attualmente, non essendo più sostenibile la concezione di “vis vitalis”, i supporters dell’omeopatia si aggrappano all’idea che la struttura dell’acqua sia come un materasso memory-foam. In pratica, sulla base di lavori scientifici di cui si è dimostrata l’inconsistenza,[15] viene affermato che la validità dell’omeopatia risiede nel fatto che la struttura dei “clusters” dell’acqua è modificata dalla presenza del principio attivo. L’impronta del principio attivo rimane inalterata nei processi di diluizione. L’alterazione della struttura dei “clusters” indurrebbe delle variazioni nei campi elettromagnetici generati dagli elementi che compongono l’acqua. Sono questi campi elettromagnetici che indurrebbero il processo di guarigione dell’organismo malato.[15] A parte l’inconsistenza scientifica delle affermazioni anzidette (nessuna di esse è mai stata provata), proviamo a ragionare sulle alterazioni dei campi elettromagnetici.

6 – Dissociazione dell’acqua (M. Almagro Rivas/Commons CC-BY-SA 4.0).

Una tecnica analitica molto nota in chimica è la risonanza magnetica nucleare.[16] Essa si basa sull’alterazione delle caratteristiche fisiche dei nuclei presenti nelle molecole grazie all’applicazione di campi magnetici aventi ben precise intensità. Senza entrare troppo nei dettagli che sono oltre gli scopi di questa nota, basti sapere che l’uso dei campi magnetici ad intensità variabile consente di monitorare la dinamica (ovvero il movimento) delle molecole di acqua in tutte le condizioni.[17]. Se i “clusters” dell’acqua fossero come i materassi memory-foam, ovvero se la rete tridimensionale di legami a idrogeno fosse modificata dall’impronta del principio attivo, ci dovremmo aspettare dinamiche differenti delle molecole di acqua soggette alle deformazioni anzidette. Queste dinamiche si dovrebbero riflettere sulla velocità con cui un nucleo (nella fattispecie quelli degli atomi di idrogeno dell’acqua) cede la sua energia per effetto dell’interazione con i campi magnetici ad intensità variabile. Ed invece il modello matematico che descrive la velocità appena citata[18]indica chiaramente che al tendere a zero della concentrazione di soluto (ovvero di un qualsiasi composto disciolto in acqua), l’acqua si comporta esattamente come se non avesse mai contenuto alcun soluto. Non c’è alcuna traccia della memory-foam, ovvero dell’impronta lasciata dal soluto nella rete tridimensionale dei legami a idrogeno. Questa riportata è solo una delle tante prove contro la memoria dell’acqua. Molte altre se ne possono trovare in letteratura e molti lavori pubblicati evidenziano gli errori commessi negli esperimenti a supporto della fantomatica memoria dell’acqua.[15] Da dove nasce la fama della memoria dell’acqua? Dal fatto che l’industria omeopatica è molto remunerativa: i formulati omeopatici costano parecchio e possono essere considerati a ragion veduta un vero e proprio lusso. Individuare una pseudo spiegazione scientifica aiuta molto nel marketing e nella vendita di prodotti omeopatici incrementando, in questo modo, l’indotto economico e l’arricchimento di gente senza scrupoli che sfrutta la credulità della gente. Inoltre, la pseudo spiegazione ammanta di scientificità qualcosa che scientifico non è, mettendo in pace l’animo delle persone che temono le proprie paure e hanno necessità di rivolgersi all’omeopatia. A nulla vale l’avvertimento in base al quale un formulato omeopatico funziona meglio se si fa una vita sana. Se si fa una vita sana, ovvero alimentazione corretta senza eccessi e sana attività fisica, non c’è bisogno né di medicinali veri e propri né di formulati omeopatici. Neanche vale dire che in caso di malattia conclamata il formulato omeopatico coadiuva le cure più tradizionali dall’efficacia acclarata. Lavori di letteratura dimostrano chiaramente che l’attività dei formulati omeopatici è del tutto simile al placebo[19] per cui, a parte influenzare l’approccio psicologico del paziente con la malattia, non hanno alcuna utilità medica.

7 – “Un paziente soffre gli effetti dell’omeopatia”, mentre l’omeopata, dietro alla colonna, si fa beffe di lui. Cromolitografia, 1850 c.a (Wellcome Images, CC-BY-SA 4.0).

Il falso mito dei miliardi di molecole nelle preparazioni omeopatiche

Ho già avuto modo di scrivere in merito al mito secondo cui i preparati omeopatici sono efficaci perché conterrebbero ancora miliardi di molecole di principio attivo.[20] Tuttavia, come dicevano i nostri antenati “repetita iuvant”. Innanzitutto, l’affermazione secondo cui in un formulato omeopatico si “agitano” miliardi di molecole fa un poco a pugni sia con la presunta memoria dell’acqua che col fatto che un prodotto omeopatico non è considerato un farmaco vero e proprio. Forse chi fa questa affermazione non si rende neanche conto che contraddice se stesso. Se il formulato omeopatico contiene miliardi di molecole di principio attivo, allora, secondo chi afferma ciò, la sua presunta efficacia è dovuta al fatto che può essere considerato alla stregua di un farmaco vero e proprio. E se è così, perché i formulati omeopatici non sono soggetti alla stessa legislazione (nazionale ed internazionale) dei farmaci veri e propri secondo cui prima di essere immessi nel mercato essi devono superare dei test molto stringenti in merito alla loro tossicità? Se l’attività dei formulati omeopatici è dovuta alla presunta presenza di miliardi di molecole, perché c’è bisogno di trovare una spiegazione scientifica in merito alla memoria dell’acqua dal momento che sono i miliardi di molecole ancora presenti ad avere una qualche attività?

Ma veniamo al punto. Chi afferma che nei formulati omeopatici ci sono miliardi di molecole che si agitano, non dice una sciocchezza vera e propria. Sta semplicemente usando una parte dei fatti rigirandoli a proprio uso e consumo secondo delle abitudini che sono consolidate e riconosciute. In ambito scientifico si parla di “cherry picking”, ovvero, tra tutto ciò che mi serve, prendo solo le informazioni che fanno comodo al mio caso e mi consentono di avallare le mie idee. Si chiama anche “bias cognitivo”. Si tratta della nostra predisposizione a voler prendere in considerazione solo ed esclusivamente ciò di cui siamo già convinti. Questi sono errori in cui possono incorrere tutti. Tuttavia, chi si occupa di scienza è, in genere, più allenato delle persone comuni, che non hanno basi scientifiche, e sanno riconoscere, per lo più, queste fallacie. Ai fini esemplificativi sono costretto ad entrare in alcuni tecnicismi che spero di spiegare nel modo più semplice possibile senza appesantire un discorso già pesante e tecnico di suo.

Prendiamo in considerazione una soluzione acquosa satura[21] di vitamina C (anche definito come acido ascorbico) che corrisponde ad una concentrazione di 1.87 mol/L ed indicata anche come 1.87 M.[22] Diluiamo questa soluzione di acido ascorbico (che tecnicamente si chiama soluzione madre) in un rapporto 1 : 100 con acqua. Diluire 1 : 100 significa che preso 1 della soluzione madre aggiungo 99 di acqua. Naturalmente mi sto riferendo ai volumi, per cui 1 mL di soluzione madre viene addizionato con 99 mL di acqua. Quale sarà la concentrazione finale? È facile. Basta semplicemente dividere la concentrazione della soluzione madre per 100, ovvero il volume espresso in millilitri della soluzione finale. Quindi la nuova soluzione ha concentrazione 1.87 x 10^(-2) M. Andiamo avanti e diluiamo la nuova soluzione in rapporto 1 : 100. Si ottiene una soluzione la cui concentrazione è la centesima parte di quella iniziale, quindi: 1.87 x 10^(-4) M. Se continuiamo n volte, la soluzione finale avrà concentrazione 1.87 x 10^(-2n) M. Nel linguaggio usato dagli omeopati sto facendo le famose diluizioni CH, ovvero centesimali, per cui:

CH = 1.87 x 10^(-2) M

2CH = 1.87 x 10^(-4) M

………

nCH = 1.87 x 10^(-2n) M